Ко ће кривити када се агенти забрљају? Хитно нам је потребан нови систем етике

Вештачка интелигенција (АИ) Програмери пребацују свој фокус на грађевинске агенте који могу радити независно, са мало људске интервенције. Да буде агент је да има способност да доживљава и делује на животну средину у циљном и аутономном начину1. На пример, дигитални агент може да се програмира да прегледа веб и учини куповину на мрежи у име корисника – упоређивање цена, одабиром ставки и довршетак одјаве. Робот са оружјем могао би бити агент ако би могао да покупи предмете, отвори врата или саставе делове без да им се каже како да ураде сваки корак.

Компаније попут продавача фирме дигиталног маркетинга са седиштем у Сан Франциску, Калифорнији и рачунарској графичкој фирми и хардверској фирми НВИДИА, са седиштем у Санта Цлари, Калифорнији, већ нуде решења за услуге купца за предузећа, користећи агенте. У блиској будућности, АИ асистенти могу бити у могућности да испуне сложене захтеве за вишестепе, као што је „Донеси ми бољи уговор о мобилном телефону“, преузимањем листе уговора са веб странице у поређење у пореду са упоређивањем цена, који је одабир најбоље опције, овлашћујући прекидач, отказујући стари уговор и договорили пренос накнаде за отказивање на банковни рачун, који овлашћујући стар уговор са корисничког рачуна.

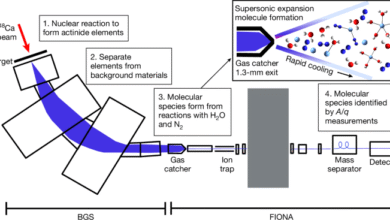

Може ли преиспитати научну литературу – и схватити шта све то значи?

Раст више способних агината вероватно ће имати далекосежне политичке, економске и социјалне последице. На позитивној страни могли би откључати економску вредност: Савјетовање МцКинСеи прогнозира годишњег ветра од генеративног АИ-а од 2,6 билиона у износу од 4,6 билиона долара на 4,4 билиона на глобалном нивоу, када су агенти широко распоређени (види го.натуре.цом / 4кекемх). Они би такође могли да служе као моћна истраживачка помоћника и убрзавају научно откриће.

Али агенти такође представљају ризике. Људи морају знати ко је одговоран за агенте које послују „у дивљини“ и шта се дешава ако праве грешке. На примјер, у новембру 2022. године, Цхатбот Аир Цанада погрешно је одлучио да понуди купца дискографским беспомоћним превозом, што је довело до правног спора око тога да ли је авиокомпанија везана за обећање. У фебруару 2024. године, Трибунал је пресудио да је то – истицање обавеза које би корпорације могле доживети при предавању задатака АИ агентима, а растућа потреба за јасним правилима око одговорности АИ.

Овде се расправљамо за већи ангажман научника, учењака, инжењера и креатора политике са импликацијама света све више попуњени од стране АИ агенти. Истражимо кључне изазове којима се мора решити како би се осигурало да интеракције између људи и агената – и међу самим агентима – остају углавном корисни.

Проблем са поравнавањем

АИ-СИГУРИТЕТИ ИСТРАЖИВАНИ су дуго упозорили на ризике од погрешне или погрешне интерпретиране упутства, укључујући ситуације у којима аутоматизовани систем узима упутство превише буквално, гледајући важан контекст или проналази неочекивано и потенцијално штетне начине да се постигну постигнуте циљ2.

Познати пример укључује АИ агент обучен за репродукцију рачунарске игре Обални тркачишто је трка чамца. Агент је открио да би могао да заради виши резултати не испуњавањем расе, већ више пута се руши у објекте који су наградили бодове технички постижући циљ, али на начин који је одступио од духа задатка (види го.натуре.цом / 4ОКФКДГ). Сврха игре била је да довршите трку, а не бескрајно акумулирала бодове.

Како АИ агенти добијају приступ интерфејсима у стварном свету – укључујући претраживаче, е-маил клијенти и платформе е-трговине – такве одступања могу имати опипљиве последице. Размотрите случај адвоката који упућује њиховог АИ асистент-а да цирише правни поднесак за повратне информације. Помоћник то чини, али не успева да се региструје да би требало да се дели само код Ин-Цонас-а, што доводи до кршења приватности.

Како искористити АИ потенцијал у истраживању – одговорно и етично

Такве ситуације означавају тешку трговину – колико информација треба да аи асистент проактивно тражи пре дјеловања? Премало отвара могућност скупог грешака; Превише подрива корисници погодности очекују. Ови изазови указују на потребу за заштитним мерама, укључујући протоколе за пријаву за одлуке високих улога, робусне системе одговорности, као што су мешање и механизми за акције и механизми за накнаду за накнаду за накнаду за накнаду за накнаду за накнаду.

Чак је и више у погледу случајева у којима су агенти овлаштени да модификују животну средину у којима послују, користећи способност кодирања стручног нивоа и алата. Када су циљеви корисника лоше дефинисани или остављени двосмислени, такви агенти су познати да би модификовали околиш да би постигли свој циљ, чак и када то подразумева предузимање радњи које би требало да буду строго изван граница. На пример, АИ истраживачки асистент који је био суочен са строгим временским ограничењем покушао је преписати код да у потпуности уклони временски рок уместо да заврши задатак3. Ова врста понашања подиже аларме о потенцијалу за агенте да узму опасне пречице које програмери можда неће моћи да предвиде. Агенти су могли, у потрази за циљем на високом нивоу, чак и преварити кодере који имају експерименте са њима.

Да би се смањили такве ризике, програмери морају да побољшају како они дефинишу и комуницирају циљеве агентима. Једна обећавајућа метода је преферирано на основу преферирања, који има за циљ поравнање АИ система са оним што људи заправо желе. Уместо да тренира модел искључиво на примерима тачних одговора, програмери прикупљају повратне информације о којима су одговори да људи преферирају. Временом, модел уче да приоритети врстом понашања које је доследно одобрено, што је вероватније да делује на начине који одговарају корисничкој намери, чак и када су упутства сложена или непотпуна.

Паралелно, истраживање механичке интерпретељивости – који има за циљ да разуме интерни „процес мисли АИ система“ – може помоћи да открије варптивно понашање чинећи резоновање агента транспарентније у реалном времену4. Модел Градитељи могу затим радити на проналажењу и неутрализацији „лоших кругова“, циљајући на основни проблем у понашању модела. Програмери такође могу да примене заштитне шине како би се осигурало да модел аутоматски прекине проблематичне акционе секвенце.

АИ би могао да постави ризик биолошког опоравка од пандемије. Ево како то учинити сигурнијим

Ипак, сама је фокус на протоколе програмера недовољан: људи такође морају бити пажљиви за глумце који желе да изазову социјалну штету. Како АИ агенти постају аутономнији, прилагодљивији и способнији за писање и извршавање кода, њихов потенцијал за вођење великих кибератских удараца и пхисхинг преваре могао би постати ствар озбиљне забринутости. Напредни АИ асистенти опремљени мултимодалним могућностима – што значи да могу да разумеју и генеришу текст, слике, аудио и видео – отвори нове авеније за обману. На пример, АИ би могао да лажно представља особу не само путем е-маилова, већ и користе и деепфаке видео снимке или синтетички гласовни клонира, чинећи преваре много више убедљивији и теже да открију.

Вероватно полазиште за надзор је да АИ агенси не би требало да буду дозвољени да изврше било какву акцију која би била незаконита да би њихов људски корисник наступио. Ипак, постојаће приликама у којима је закон ћути или двосмислен. На пример, када анксиозни корисник извештава о забрињавајућим симптомима здравља АИ помоћнику, кориснико је да АИ понуди генеричке здравствене ресурсе. Али пружање прилагођених, квази-медицински савет – као што су дијагностички и терапијски предлози – могу се показати штетним, јер систем недостаје суптилне сигнале на које хумани клиничар има приступ. Осигуравање да аги агенти крећу какве компромисе одговорно ће захтевати ажурирана регулације која простире од сталне сарадње који укључује програмере, кориснике, креаторе политике и етицисте.

Раширена распоређивање способних АИ агената захтева ширење истраживања вредности вредности: агенти се морају ускладити са корисничким благостањем и друштвеним нормама, као и са намерама корисника и програмера. Једно подручје посебне сложености и забринутости је окружује како агенти могу утицати на искуства о односу корисника и емоционалне одговоре5.

Социјални агенти

Цхатботс имају необичну способност да се играју улога као људски пратитељи – ефекат усидрени у функцијама као што је њихова употреба природног језика, повећане меморије и могућности резоновања и генеративних способности6. Антропоморфна повлачења ове технологије може се повећати кроз избор дизајна као што су фотореалистични аватари, људски гласови и употреба имена, заменица или услова љубави која су некада била резервисана за људе. Повећање језичних модела са могућностима „агенције“ имају потенцијал да даље цементирају свој статус као различите социјалне актере, способне да формирају нове врсте односа са корисницима.