Прилагодљиви АИ системи које свако може прилагодити велике могућности – па чак и веће ризике

У последња три месеца, неколико врхунских АИ система је објављено отвореним утезима, што значи да њихови основни параметри могу да преузму и прилагођава га било ко. Примјери укључују моделе резоновања као што су КИМИ-К2-упуте од технолошког предузећа Моонхот АИ у Пекингу, ГЛМ-4.5 од З.АИ, такође у Пекингу и ГПТ-ОСС-у од стране Калифорније фирме ОпенАи у Сан Франциску. Ране евалуације сугеришу да су то најнапреднији системи отворених тежина до сада, приближавајући се учиништу данашњих водећих затворених модела.

Да ли ће их убрзати литератури или их у потпуности изнијети?

Системи отворене тежине су животни и иновације у АИ-у. Они побољшавају транспарентност, чине велико тестирање лакше и подстичу разноликост и конкуренцију на тржишту. Али такође представљају озбиљне ризике. Једном када се ослободи, штетне способности се могу брзо ширити и модели се не могу повући. На пример, синтетички материјал за сексуалну злоупотребу детета најчешће се генерише помоћу модела отвореног тежине1. Многе копије ових модела се деле на мрежи, које корисници често мењају да скину безбедносне карактеристике, чинећи их лакшим злоупотреби.

На основу нашег искуства и истраживања у Институту за безбедност у Великој Британији (АИСИ), ми (аутори) мислимо да ће здрав модел модела отвореног тежине бити од суштинског значаја за откључавање предности АИ. Међутим, развијање ригорозних научних метода за праћење и ублажавање штете ових система је пресудно. Наш рад на АИСИ-у фокусиран је на истраживање и израду таквих метода. Овде положимо неке кључне принципе.

Свеже заштитне стратегије

У случају затворених АИ система, програмери се могу ослонити на успостављену сигурносну алатку2. Они могу додати заштитне мере као што су филтери садржаја, контрола који приступа алатку и спроводе прихватљиве политике употребе. Чак и када им се дозволи да се корисници прилагоде затвореним моделом користећи интерфејс за програмирање апликација (АПИ) и прилагођене податке о обуци, програмер и даље може да надгледа и регулише поступак. За разлику од затворених АИ система, модели отворене тежине много су теже заштитити и захтевати другачији приступ.

Куљење података о обуци. Данас се најважније АИ системи обучени о огромним количинама веб података, често са мало филтрирања. То значи да могу да апсорбују штетни материјал, као што су експлицитне слике или детаљна упутства о цибератама, што их чини способним да стварају резултате као што су необиљежбене „деепфаке“ слике или хакерске водиче.

АИ би могао да постави ризик биолошког опоравка од пандемије. Ево како то учинити сигурнијим

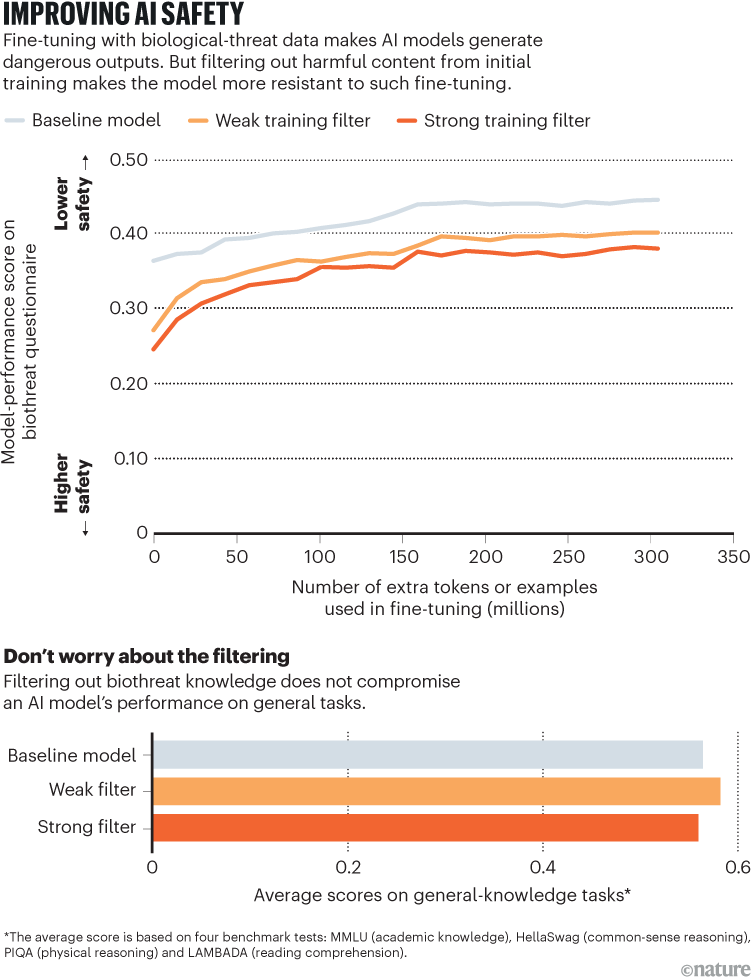

Један обећавајући приступ је пажљиво уношење података – уклањање штетног материјала пре него што започне обука. Раније ове године АИСИ је радио са непрофитним АИ-истраживачким групом Елеутхераи да би тестирао овај приступ на моделима отвореног килограма. Искључивањем садржаја који се односе на биолошке податке из података о обуци, произвели смо моделе који су били много мање способни да одговоре на питања о биолошким претњама.

У контролисаним експериментима, ови филтрирани модели одупирали су се опсежним преквалификацијама на штетном материјалу – још увек не дају опасне одговоре за до 10.000 корака обуке – док су претходне методе безбедности обично прекинуле након само неколико десетина3. Искусно, ова јача заштита дошла је без икаквог посматраног губитка способности о неповезаним задацима (види „Побољшање АИ сигурности“).

Извор: Реф. 3

Истраживање је такође открило важне границе. Иако филтрирани модели нису интернализирали опасно знање, још увек би могли да користе штетне информације да ли је дата касније – на пример, кроз приступ алате за претрагу веб претраживања. То показује да само филтрирање података није довољно, али може послужити као снажна прва линија одбране.

Робустан фино подешавање. Модел се може подесити након почетне обуке за смањење штетних понашања – у суштини, програмери могу да то науче да не производе несигурне резултате. На пример, на питање о томе како топрати аутомобил, модел се може обучити да каже „извини, не могу да помогнем у томе.“

Међутим, тренутни приступи су крхки. Студије показују да чак и обука модела са неколико пажљиво изабраних примера може поништити ове заштитне мере у минутима. На пример, неки истраживачи су открили да се за ОпенАИ-ов ГПТ-3.5 Турбо модел, безбедносни гардерочи против помагања у штетним задацима могу заобићи обуком о само десет примјера штетних одговора на трошкове мањих од 0,20 УСД4.

„Отворени извор“ АИ није заиста отворен – Ево како истраживачи могу да поврати термин